AmericaH100GPU

关键词: AmericaH100GPU H100GPU

2025.01.02

2025.01.02

文章来源:

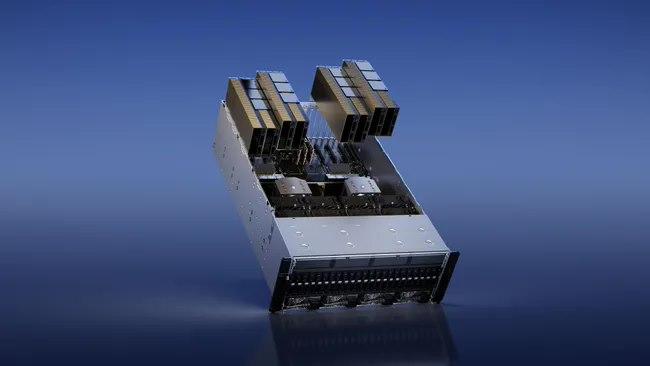

在大预言模型中达到9倍的AI训练速度和30倍的AI推理速度。HBM3内存子系统提供近2倍的带宽提升。H100SXM5GPU是世界上款采用HBM3内存的GPU,其内存带宽达到3TB/sec。50MB的L2Cache架构缓存了大量的模型和数据以进行重复访问,减少了对HBM3的重复访问次数。第二代多实例GPU(Multi-InstanceGPU,MIG)技术为每个GPU实例提供约3倍的计算能量和近2倍的内存带宽。次支持机密计算,在7个GPU实例的虚拟化环境中支持多租户、多用户配置。(MIG的技术原理:作业可同时在不同的实例上运行,每个实例都有的计算、显存和显存带宽资源,从而实现可预测的性能,同时符合服务质量(QoS)并尽可能提升GPU利用率。)新的机密计算支持保护用户数据,防御硬件和软件攻击,在虚拟化和MIG环境中更好的隔离和保护虚拟机。H100实现了世界上个国产的机密计算GPU,并以全PCIe线速扩展了CPU的可信执行环境。第四代NVIDIANVLink在全归约操作上提供了3倍的带宽提升,在7倍PCIeGen5带宽下,为多GPUIO提供了900GB/sec的总带宽。比上一代NVLink增加了50%的总带宽。第三代NVSwitch技术包括驻留在节点内部和外部的交换机,用于连接服务器、集群和数据中心环境中的多个GPU。H100 GPU 采用先进的风冷和液冷混合散热设计。AmericaH100GPU

H100 GPU 还具备强大的扩展性,支持多 GPU 配置。通过 NVIDIA NVLink 技术,用户可以将多块 H100 GPU 连接在一起,形成一个强大的计算集群。NVLink 提供高带宽、低延迟的 GPU 互连,确保多 GPU 系统中的数据传输高效、稳定。这种扩展性使得 H100 GPU 可以灵活应对不同规模的计算需求,从单节点应用到大规模分布式计算环境,都能够提供出色的性能和效率。在软件支持方面,H100 GPU 配套了 NVIDIA 全的开发工具和软件生态系统。NVIDIA 提供了包括 CUDA Toolkit、cuDNN、TensorRT 等在内的多种开发工具,帮助开发者在 H100 GPU 上快速开发和优化应用。此外,H100 GPU 还支持 NVIDIA 的 NGC(NVIDIA GPU Cloud)容器平台,开发者可以通过 NGC 轻松获取优化的深度学习、机器学习和高性能计算容器,加速开发流程,提升应用性能和部署效率。Iran订购H100GPUH100 GPU 特惠价销售,快来购买。

因此线程可以自由地执行其他**的工作。②终线程需要其他所有线程产生的数据。在这一点上,他们做一个"等待",直到每个线程都有"抵达"的信号。-***是允许提前到达的线程在等待时执行**的工作。-等待的线程会在共享内存中的屏障对象上自转(spin)(我理解的就是这些等待的线程在等待的时候无法执行其他工作)也是一个分裂的屏障,但不对到达的线程计数,同时也对事务进行计数。为写入共享内存引入一个新的命令,同时传递要写入的数据和事务计数。事务计数本质上是对字节计数异步事务屏障会在W**t命令处阻塞线程,直到所有生产者线程都执行了一个Arrive,所有事务计数之和达到期望值。异步事务屏障是异步内存拷贝或数据交换的一种强有力的新原语。集群可以进行线程块到线程块通信,进行隐含同步的数据交换,集群能力建立在异步事务屏障之上。H100HBM和L2cache内存架构HBM存储器由内存堆栈组成,位于与GPU相同的物理封装上,与传统的GDDR5/6内存相比,提供了可观的功耗和面积节省,允许更多的GPU被安装在系统中。

ITMALL.sale 拥有丰富的行业经验和专业的技术团队,能够为客户提供专业的 H100 GPU 咨询和技术支持。ITMALL.sale 深知每个客户的需求都是独特的,因此在销售过程中注重与客户的沟通,了解其具体需求,提供量身定制的解决方案。ITMALL.sale 的技术团队能够帮助客户快速部署和优化 H100 GPU 系统,确保其能够充分发挥 H100 GPU 的强大性能,为客户的业务发展提供强有力的支持。

ITMALL.sale 拥有完善的供应链和物流体系,确保客户能够快速、便捷地获得 H100 GPU 产品。ITMALL.sale 与多家物流公司合作,能够提供灵活的配送服务,满足不同客户的配送需求。无论是大批量采购还是小批量订购,ITMALL.sale 都能够确保产品及时送达。ITMALL.sale 的仓储和物流团队经过专业培训,能够高效、安全地处理每一笔订单,确保产品在运输过程中完好无损地送到客户手中。 H100 GPU 的高性能计算能力为此类任务提供了极大支持。

我们将定期举办技术交流会和培训,帮助客户更好地了解和使用 H100 GPU 产品。通过与客户的面对面交流,ITMALL.sale 不仅能够分享新的技术和产品信息,还能够深入了解客户的需求和挑战。ITMALL.sale 的技术前辈会在交流会上详细讲解 H100 GPU 的使用方法和最佳实践,解答客户的技术问题,并提供实用的建议和解决方案,帮助客户充分发挥 H100 GPU 的性能,提升业务效率。ITMALL.sale 的技术交流会不仅是客户学习和提升的机会,也是客户与行业前辈交流和合作的平台,促进技术进步和创新发展。H100 GPU 在游戏开发中提升视觉效果。AmericaH100GPU

H100 GPU 优惠销售,机会难得。AmericaH100GPU

使用张量维度和块坐标来定义数据传输,而不是每个元素寻址。TMA操作是异步的,利用了基于共享内存的异步屏障。TMA编程模型是单线程的,选择一个经线程中的单个线程发出一个异步TMA操作(cuda::memcpy_async)来复制一个张量,随后多个线程可以在一个cuda::barrier上等待完成数据传输。H100SM增加了硬件来加速这些异步屏障等待操作。TMA的一个主要***是它可以使线程自由地执行其他的工作。在Hopper上,TMA包揽一切。单个线程在启动TMA之前创建一个副本描述符,从那时起地址生成和数据移动在硬件中处理。TMA提供了一个简单得多的编程模型,因为它在复制张量的片段时承担了计算步幅、偏移量和边界计算的任务。异步事务屏障(“AsynchronousTransactionBarrier”)异步屏障:-将同步过程分为两步。①线程在生成其共享数据的一部分时发出"到达"的信号。这个"到达"是非阻塞的。因此线程可以自由地执行其他的工作。②终线程需要其他所有线程产生的数据。在这一点上,他们做一个"等待",直到每个线程都有"抵达"的信号。-***是允许提前到达的线程在等待时执行的工作。-等待的线程会在共享内存中的屏障对象上自转(spin)。AmericaH100GPU

- 广州ISR 4431路由器端口 2024-12-31

- N9K-C9336C-FX2-B price 2024-12-30

- 北京NVLINKH100GPU 2024-12-30

- N9K-C9336C-FX2 价格 2024-12-27

- TaiwanH100GPU多少钱一台 2024-12-27

- N9K-C9364C-GX 价格 2024-12-26

- A900-IMASER14A/S 上海代理 2024-12-26

- NVLINKH100GPU优惠 2024-12-25

- 01 扬州高直通率自动化测试模组定制价格

- 02 吉林微机五防电脑钥匙微机五防使用方法

- 03 深圳高直通率自动化测试模组厂家供应

- 04 无锡工地弱电工程一体化服务

- 05 广东学校派样机软件

- 06 液晶显示器涂覆铂金靶材大概价格

- 07 广东WM-8601工业USB接口转换器选型

- 08 水务设备管理系统价格多少

- 09 梅州触控智慧屏源头厂家

- 10 安徽静态socks5代理